AI 인식‧판단 이해 돕는 '설명 가능성' 연구로 신뢰성 높여

AI 설명 연구, 다양한

탐색‧표현 기술 개발해 실생활 적용

국내외 기업, AI 기술

적용해 생성·오류·제어 발생 근거 제시

“인공지능 로봇, 인지적 작업에서도 인간과 경쟁하는 경우 늘어날 것” - Richard Freeman 미국 하버드대 교수

아카이브(ArXiv)에 공개된 컴퓨터(CS) 분야 논문들 가운데 ‘Explainable(설명 가능한)’이란 키워드 제목을 포함하는 논문 수가 지난 2015년 9건에서 2019년 236건으로 급증했다.

심층학습(딥러닝) 기반 AI 기술의 발전으로 인해 개별 태스크의 성능이 비약적으로 개선됐으나, AI 모델의 구조와 학습‧판단 과정은 매우 복잡하기에 AI가 어떻게 학습하고

판단하는지에 대한 이해는 더 어려워졌기 때문.

이에 블랙박스 형태의 AI 모델 내부를 분석함으로써 AI의 인식‧판단 결과에 대한 근거를 사용자가 이해할 수 있도록 돕는 '설명 가능성' 연구가 최근 주요 주제로 떠오르게

됐다.

'설명 가능한 AI'는 AI의 판단 이유와 근거 제시를 통해 AI 인식 결과에

대한 신뢰성을 확보한다. 이는 실생활에서 인간과 AI 간의 협업을 위한 필수적인 요소로도 주목받고 있으며, 특히 사람의 이해와 관련돼 있다는 관점에서 심리학과의 학제 간 연구도 함께 진행되고

있는 추세다.

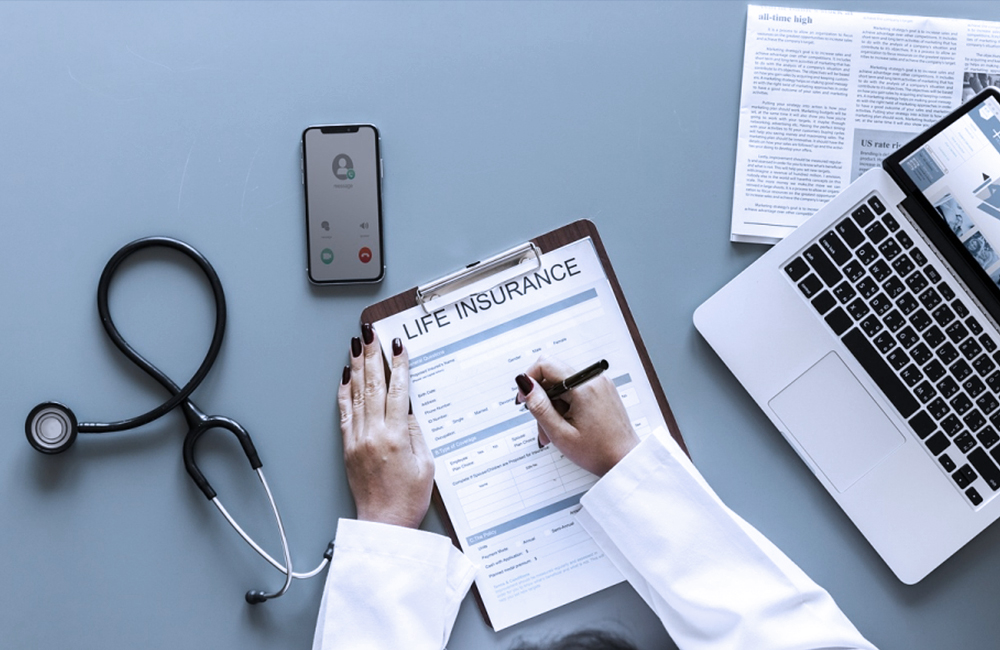

(사진=셔터스톡).

◆ 기술 동향

설명 가능한 AI 연구 가운데 가장 활발한 연구분야인 시각 분야에서는 설명 가능성을 위한 기법이 많이 제안되고 있다. 지난 2015년 옥스퍼드대는 딥러닝 모델에서 각 계층의 표현을 반전시키는 반전 표현(Invert Representation) 기술을

개발해 CNN(콘볼루션‧합성곱

신경망) 모델의 각 계층에 표현된 정보를 조명한 바 있다.

국내의 경우 2017년부터 2021년까지 과기부/IITP XAI 프로젝트를

통한

연구가

수행되고

있다.

▲설명

가능한

인과관계

학습

추론

기술

▲설명

가능한

원샷‧제로샷 학습 모듈 ▲의사결정의 이유 제시를 위한 설명 가능한 인터페이스 ▲설명 가능한 AI의 실세계 적용 등 4가지 주제 연구가 중점적으로 이뤄지는 중.

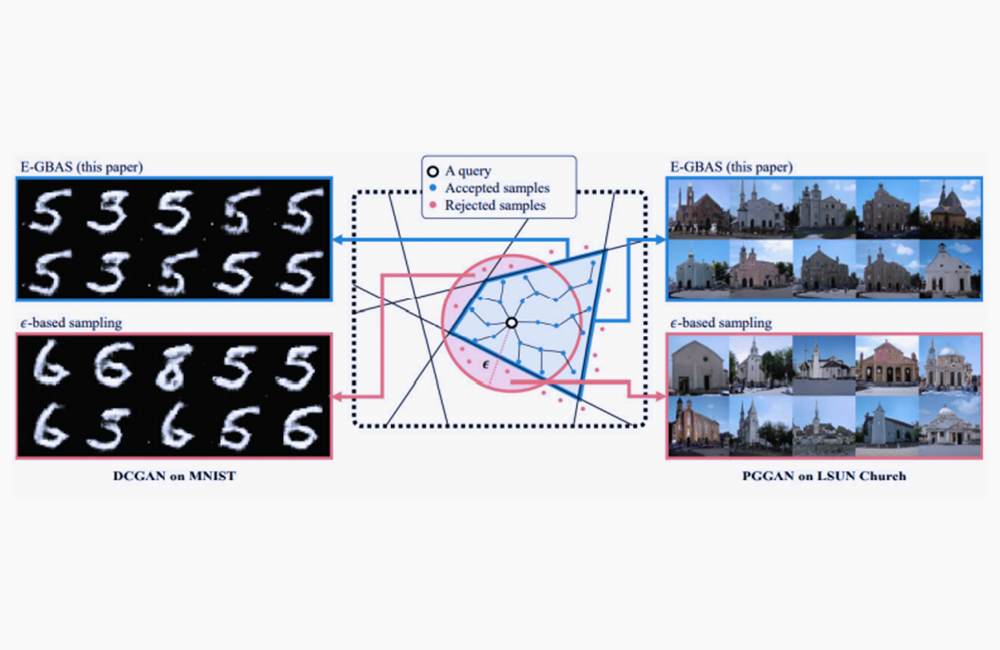

지난해 울산과학기술원(UNIST)과 한국과학기술원(KAIST)은

생성

네트워크의

특정

레이어에

대해

주어진

예제와

동일한

예제를

생성하는

생성

바운더리(Generative Boundary)를 탐색, 생성 네트워크의 내부를 설명하는 기술을 연구했다.

아울러 AI 솔루션 개발 기업 '에이아이트릭스(AITRICS)'는

카이스트

설명

가능

인공지능

연구센터와

협력해, 환자 상태 변화를 설명할 수 있는 방법을 예측하는 기술을 개발 중이다.

(UNIST, KAIST) 입력 예제와 동일한 예제를 생성하는 생성 바운더리 탐색 기술. (사진=정보통신기획평가원(IITP) '인공지능 기술 청사진 2030').

◆ 시장 동향

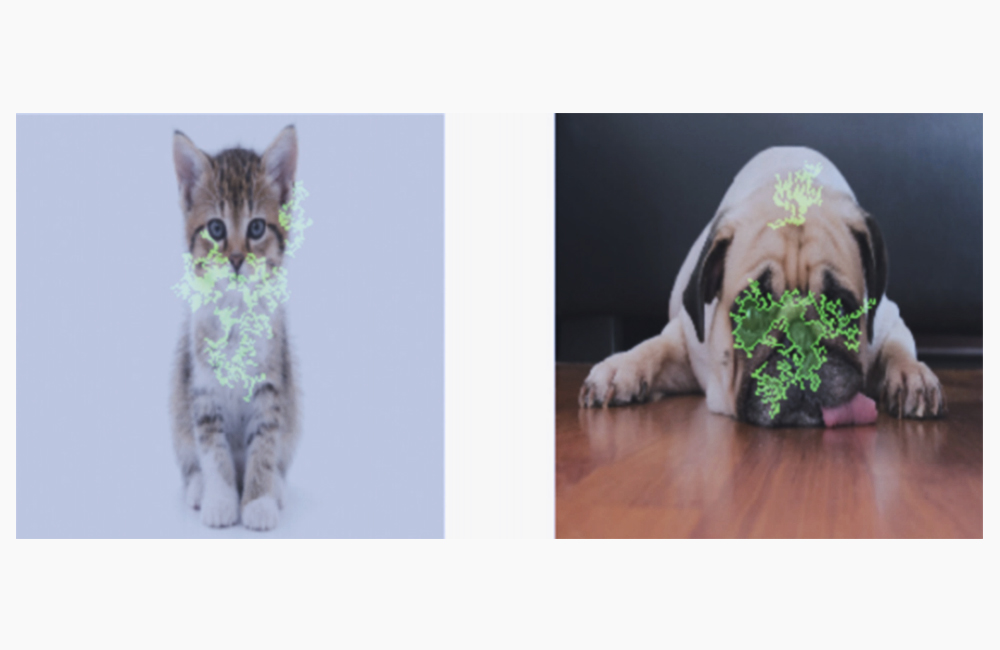

페이스북은 파이토치(Pytorch) 모델에 설명 가능성을 제공하는 Captum 라이브러리를

개발해 오픈소스로 공개했다.

또 구글은 텐서플로우(TensorFlow)

2.0 모델에 설명 가능성을 제공하는 Tf-Explain 라이브러리를 발표하고 클라우드 기반 '설명 가능한 AI(Explainable AI) 서비스'를 선보였다. 이 서비스는 테스트 케이스 예측에

모델의 각 특성이 기여한 정도를 시각화해 제공한다.

구글 클라우드의 설명 가능한 AI(Explainable AI) 서비스. (사진=정보통신기획평가원(IITP) '인공지능 기술 청사진 2030').

구글 클라우드의 설명 가능한 AI(Explainable AI) 서비스. (사진=정보통신기획평가원(IITP) '인공지능 기술 청사진 2030').

어도비는 지난 2019년 차세대 AI로 이해할 수 있는(Intelligible) 맥락적(Contextual)

AI 연구에 착수했다.

같은 해 일본 스카이디스크(Skydisc)는 설명 가능한 AI 기술으로 공장의 오류 발생

이유를 설명하는 모션보드 스카이 AI(MotionBoard for SkyAI) 솔루션 기술을 상용화했다. 이를 자동차 부품을 만드는

사출성형기의 결함 탐지에 적용해, 성형기의 내압 센서나 가스 온도

등의 오류 발생 이유에 대해 설명하도록 했다.

국내에서는 포스코 포항제철소가 지난해 2‧3고로에 설명 가능한 AI 기술을 적용했다. 고로의 통기성, 연소성, 용선 온도 등을 딥러닝 모델이 스스로 제어하고, XAI 기술을 적용해 제어 행동 이유를 설명하도록 하고 있다.

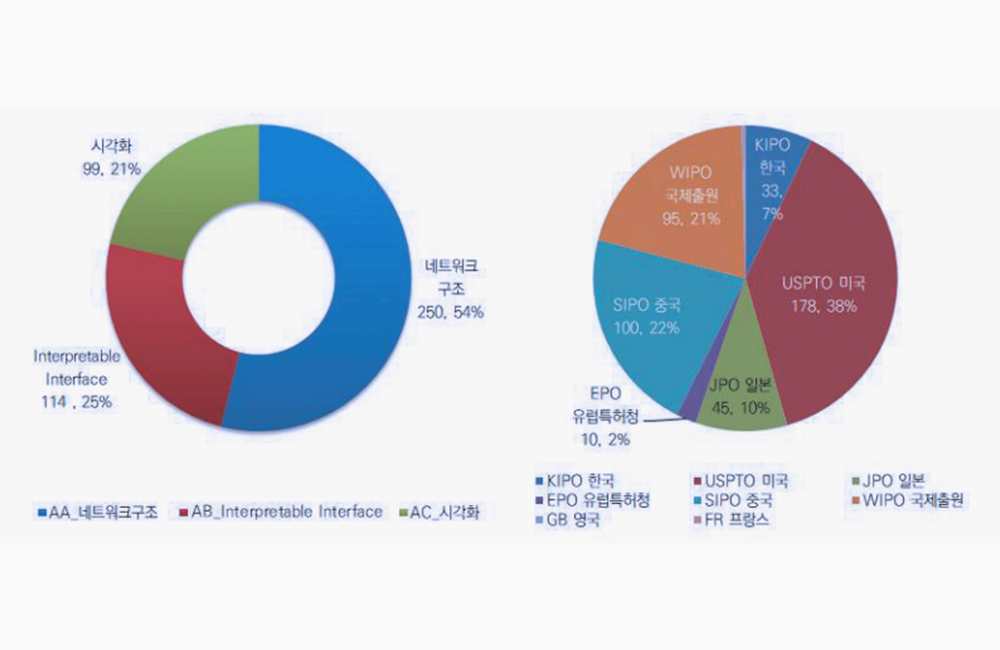

◆ 특허 동향

설명 가능한 AI 특허

동향.

(사진=정보통신기획평가원(IITP) '인공지능 기술 청사진 2030').

설명 가능한 AI 특허

동향.

(사진=정보통신기획평가원(IITP) '인공지능 기술 청사진 2030').

핵심 기술별 출원 비율은 크게 ▲네트워크 구조(54%) ▲해석가능 인터페이스(25%) ▲시각화(21%) 등으로 나뉜다. 국가별로는 미국(38%)이 가장 출원 비중이 높고, 중국(22%)과 일본(10%), 한국(7%), EU(2%) 등이 뒤를 이었다.

한편, ISO/IEC JTC 1/SC

42 중심의 국제 표준화 동향을 보면 국제표준화기구인 ISO/IEC JTC 1/SC 42 인공지능(이하 SC 42)은 AI 관련 표준을 제정하고자 2017년 11월 JTC 1 총회에서 설립 승인 후 2018년 4월 북경에서

첫 회의를 개최했다.

SC 42/WG 3 Trustworthiness 작업반은 신뢰성 확보의 필수 요소 중 하나로 설명 가능한 AI 관련 표준화를 추진하고 있다. SC 42/WG 3 대상의 설명 가능한 AI 국제 표준화는 RRA(국립전파연구원)가 ICT 국가 표준 연구 개발을 위한 AI 연구반을 중심으로 추진 중이다.